Fundierte Sprachmodelle auf proprietären Daten

Projektziele

Die Nutzung von Sprachmodellen unterliegt häufig einschränkenden Anforderungen, sogenannten Constraints. Wenn zum Beispiel lizenzrechtlich beschränkte Daten für das Training verwendet werden, sollen diese regelmäßig nicht in künstlich generierten Texten reproduziert werden. Aussagen in generierten Texten sollen darüber hinaus anhand von Quellen transparent nachvollziehbar sein. Solche und ähnliche Anforderungen sind für viele Institutionen und Unternehmen unverzichtbar für den produktiven und sicheren Einsatz von Sprachmodellen. Die Frage ist also, ob und wie Constraints bei der Konstruktion von Sprachmodellen berücksichtigt werden können. Genau hier setzt das Forschungsvorhaben „CORAL“ an und will Künstliche Intelligenz flexibler, resilienter und effizienter gestalten.

Daten

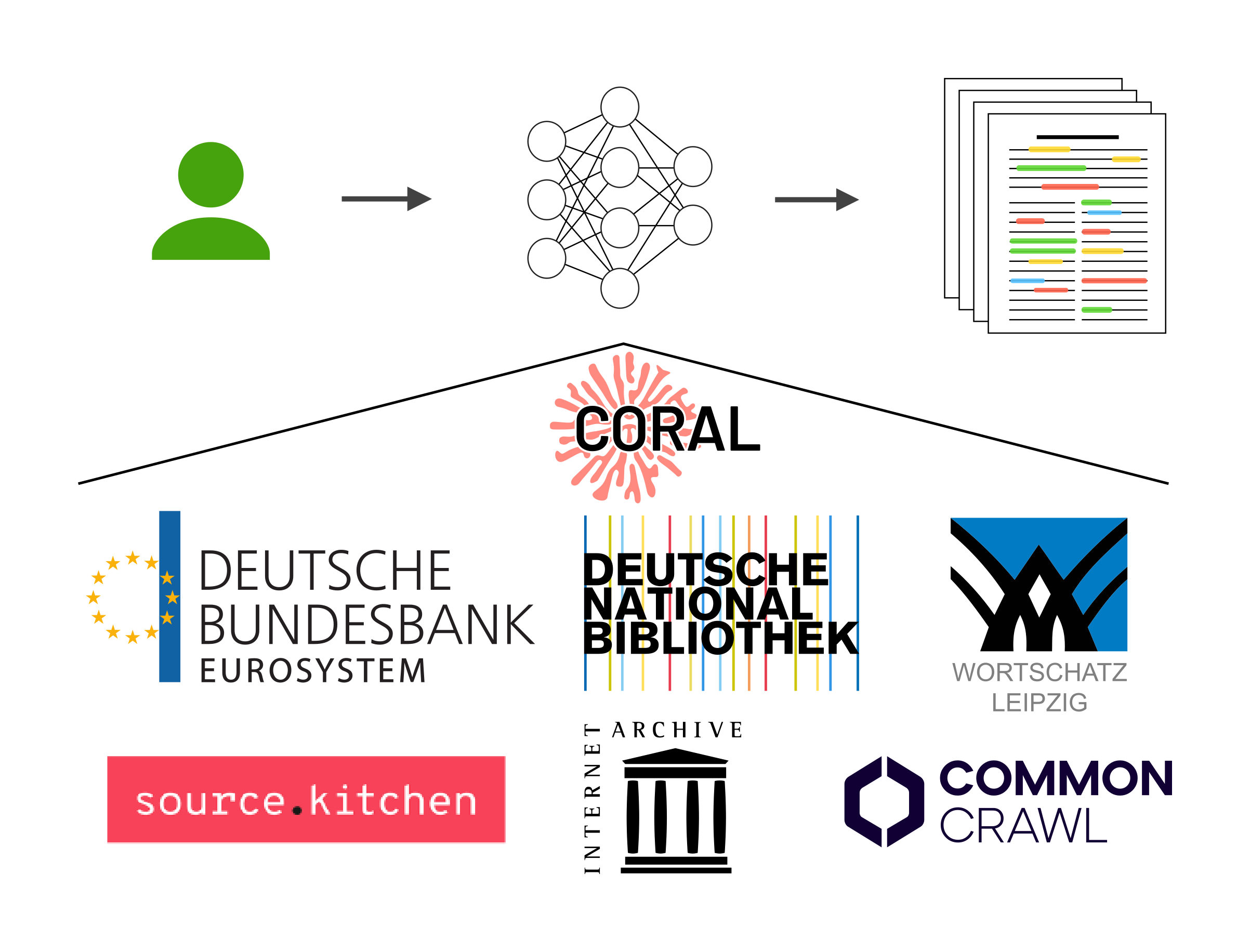

CORAL nutzt Daten der beteiligten Partner. Dazu gehören die digitalen Bestände der Deutschen Nationalbibliothek (DNB) sowie Web-Crawls aus dem Internet Archive und dem Common Crawl im Umfang von mehreren Petabyte, langjährige Crawls europäischer Nachrichten aus dem Wortschatz Leipzig und proprietäre Daten aus dem Finanzsektor. Mit Ausnahme des Common Crawls waren diese Daten bisher nicht für das Training von LLMs nutzbar, da sie aus rechtlichen Gründen nicht in ihrer ursprünglichen Form öffentlich zugänglich sind. Wir untersuchen daher, inwieweit diese Daten in obfuskierter Form rechtskonform für das Training von LLMs verwendet werden können und wie weit die Obfuskierung der Daten gehen darf, um nützliche große Sprachmodelle zu erstellen.

Vorgehen

Das Projekt untersucht, ob praktisch nutzbare Sprachmodelle auf Basis von Texten trainiert werden können, die nur in verschiedenen eingeschränkten Formen zur Verfügung gestellt werden dürfen. Außerdem werden Methoden entwickelt, um Texte unter Berücksichtigung von Fachwissen mit Quellenangaben zu generieren. Insbesondere soll die Textreproduktion aus den Trainingsdaten vermieden, jedoch vorgegebene Quellen akkurat wiedergeben, werden. Diese Verfahren werden in aufwendigen Experimenten evaluiert und mit Partnern aus dem Finanzwesen, GLAM-Institutionen (Kultur- und Gedächtnisinstitutionen) und der Privatwirtschaft getestet.

Innovationen und Perspektiven

Erwartet werden innovative Ergebnisse und Erkenntnisse in drei Kernabschnitten bei der Entwicklung und Nutzung von Sprachmodellen, sowohl in der Gesellschaft, Wissenschaft als auch Industrie: (1) Berücksichtigung bisher eingeschränkter Trainingsdaten; (2) Modellarchitekturen unter Berücksichtigung von Constraints, die u.a. die Reproduktion von Trainingsdaten vermeiden und (3) Verweis auf relevante und verlässliche Quellen, auf die der generierte Text basiert. Durch den exemplarischen Transfer dieser Ansätze werden Flexibilität als auch Effektivität sicher demonstriert.

Research Questions

Zentrale Forschungsfragen sind: Welche Trainingsmethoden und Modellarchitekturen sind robust gegenüber Datenbeschränkungen? Wie ressourceneffizient lassen sich nützliche große Sprachmodelle trainieren? Welche Methoden der Verschleierung, des Verlernens und der negierten Augmentierung verhindern wirksam die Offenlegung geschützter Daten? Wie können die Transparenz und Solidität, Originalität und Referenzierbarkeit der generierten Texte sichergestellt werden? Wie anfällig sind die Methoden zur Sicherung der Trainingsdaten von LLMs?

CORAL leistet damit einen wichtigen Beitrag zur Etablierung eines deutschen Marktes für große Sprachmodelle.

Events

Poster Presentation. The German Commons – 154 Billion Tokens of Openly Licensed Text for German Language Models. Lukas Gienapp at All Hands Meeting of the Network of German Centres of Excellence for AI Research in November 2025

Poster Presentation. CORAL: Constrained Retrieval-Augmented Language Models. Christopher Schröder at All Hands Meeting of the Network of German Centres of Excellence for AI Research in November 2025

Dagstuhl Seminar. Retrieval-Augmented Generation – The Future of Search? Martin Potthast (co-organizer), Sebastian Heineking (participant)

Keynote Presentation. Who writes the web? Who reads it? Who judges it? And who reports back to us? About authenticity in information retrieval. Martin Potthast at 15th International Conference on Innovative Concepts and Theories in Information Retrieval (ICTIR 2025) in July 2025

Poster Presentation. Learning Effective Representations for Retrieval Using Self-Distillation with Adaptive Relevance. Lukas Gienapp at 15th International Conference on Innovative Concepts and Theories in Information Retrieval (ICTIR 2025) in July 2025

Conference Talk. Axioms for Retrieval-Augmented Generation. Jan-Heinrich Reimer at 15th International Conference on Innovative Concepts and Theories in Information Retrieval (ICTIR 2025) in July 2025

Conference Talk. The Viability of Crowdsourcing for RAG Evaluation. Lukas Gienapp at 48th International ACM SIGIR Conference on Research and Development in Information Retrieval in July 2025

Invited talk. Retrieval Technologies for the Infinite Index. Martin Potthast at the 21st Conference on Database Systems for Business, Technology and Web (BTW) in Bamberg in March 2025.

Invited talk. Self-Training for Sample-Efficient Active Learning for Text Classification with Pre-Trained Language Models. Christopher Schröder at the MLT Meetings at DFKI (Online) in March 2025.

Publikationen

Daten

German Commons. A 154-billion-token pre-training corpus of openly licensed German text.

Awards

Best Paper Honourable Mention Award. For "The Viability of Crowdsourcing for RAG Evaluation". At 48th International ACM SIGIR Conference on Research and Development in Information Retrieval (SIGIR 2025)

Best Paper Honourable Mention Award. For "Axioms for Retrieval-Augmented Generation". At 15th International Conference on Innovative Concepts and Theories in Information Retrieval (ICTIR 2025)